シンデレラガールズ総選挙結果データをしゃぶりつくすツールを作った

総選挙結果閲覧ツール(別のサイトに移動します)

使い方・説明

ランキング一覧

各選挙の結果を5位ずつ表示します。総選挙結果発表時点で担当声優がいるアイドルはアイコンが付いています。

表示回を選択することで、表示する総選挙結果を変えられます。

Downボタンで次の5順位(冒頭画像の場合は6位~10位)に切り替えます。Upボタンは前の5位(6位~10位を表示している時は1位~5位)に切り替えます。

Resetボタンを押すと、1位~5位の表示に戻します。

なお、過去に2位になっているアイドルは3人をのぞいて1位になっており、なっていないアイドルは、「第2回のアナスタシア」「第4回の前川みく」「第10回の一ノ瀬志希」だけです。

総合ポイント順位

1位を50pt, 2位を49pt, ...として、選択回までの累計ポイントをランキングにしたグラフです。

圧倒的1位の高垣楓さんと、不動2位の緒方智絵里、それを追う輿水幸子、北条加蓮という形が見て取れます。

アイドルのボイス有無割合・属性別アイドル数の割合

上の表は、選択した回のボイス有りアイドル数と、属性別ランキングアイドル数の表です。

1行目はトップ10のみに注目した表で、2行目は全体の数字です。

下の折れ線グラフは、ボイス付きアイドルと各属性別アイドルのランキング数です。縦軸がランキング数で、横軸が各選挙(左から1回、2回、…)です。

なお、第10回は初めてランク入りしたアイドル全員がボイス付きとなりました。

トップ10各ランクの得票率

各総選挙トップ10の、ランク別得票率です。各回10位までの投票数合計と各順位の票数の割合です。

ポプマスの3人を選ぶツール

2021年3月16日時点の登場アイドルをランダムに3人選んで表示します。

CHANGE!!!ボタンを押すと入れ替えます。 チェックボックスが付いているタイトルのアイドルを選びます。

「タイトル重複をしない」にチェックを入れると、同じタイトルのアイドルは一人までになります。

765はミリオンでもあるけど、765PRO ALLSTARSと765PRO MILLION ALLSTARSとミリオンスターズと39プロジェクトの違いは、知ってる人でもわからなくなるので、わかりやすさ重視でこの表記になりました。

駒形友梨1st Liveの話(今さら脳直Ver)

3rdミニアルバム「a Day」発売記念ミニライブ、無料配信あるよ。

駒形友梨[スケジュール] / TEICHIKU ENTERTAINMENT

2019年2月10日 Komagata yuri 1st Live ~starting in the 〔CORE〕~ 昼公演に行った日のメモを発掘しました。あまりにも脳から直接出力したみたいでおもしろかったので、その日の楽しかった気持ちをおいておきます。

開幕

ステージの暗がりから現れた駒形さん、衣装かわいい*1!

緊張しているような集中しているような闘ってるみたいな、まっすぐな歌声で2曲。アルバムと同じ始まり*2。

3曲目でアルバムから曲順を変えて*3、しっとりとした曲が続く。

伸び伸びと歌い上げる姿に笑顔が見える。

みんな予習してるんでしょ、一緒に前奏歌ってとM-4. It's Heaven。もちろん太めのコーラスになる。

この客席にマイクを向けてる時の笑顔はこっちも笑顔になる。

アコースティックパート

ここはシングル「トマレノススメ」から。アルバム中心のセットで、どうシングルを入れるのかなぁと思ってたけど、これは良い。

フォークソング部で、アコースティックには馴染みがあると語る。

続いてシングルのカップリング「Lonely Blueが終わる頃には」。

歌いながら目をつぶり、少しだけ上を見上げてすらりと伸びる首もと、その姿は、駒形友梨のもっとも美しい姿ではないだろうか。

アコギでやるのは(鷲崎さんや学園祭学園ではあるけど)ピアノは初めじゃないかな、と。

後半パート

あまり腕を振り上げるような曲は無いけど、明るい曲もあるからクラップでお願いと、M-7. Talk 2 Night。

このあたりから、歌が好き、歌うのが楽しいという、笑顔がいっぱい。かわいい。

続いてM-8. クロックワイズ。

この曲、軽やかに歌い上げるけど、ムチャクチャ難しいことはわかる。そんなことは感じさせないけど。

M-9. はじめからきっと、これはアルバムでなくて「トマレノススメ」収録曲だけど、初回版に入ってないやつ!*4

そして、筆無精なのに作詞できるかと思ったけど、書いてみて良かったというM-10. 時の葉。

アンコール

アンコール1曲目は 「identity my ultimatum」 Sho from MY FIRST STORY feat. 駒形友梨/ウエノルカ(眩暈SIREN) ゲーム「WOR OF BRAINS」より。

ゴリゴリのメタル曲、強い。

そして「SWHINE!! キラキラ☆プリキュアアラモード」は、プリキュアのお姉さん*5だったことを思い出させる一曲。

次もプリキュアから「Lu La La☆Lumiere」、関連最後のレコーディングだったそう。神々しい曲と語ったとおり、神々しく歌い上げていた。 作曲はミリオンライブ!「永遠の花」ジェミニと同じ三好啓太さん、天才の所業。そこに豪華なことに大森祥子さんの詞。

最後はトマレノススメ。ここがスタートラインという一曲。まさにここからがスタートなんだな。

次のライブ

2020年5月31日に2ndライブが予定されていましたが、中止となってしまいました。

こちらは2ndミニアルバム「Indigo」のときにライブも2ndあるかな!と思ったけどそれはなくて、3rdミニアルバム「a Day」発売になって満を持しての2ndライブ。期待は大きかったのですが、しょうがありませんね。また次を楽しみにしています。

冒頭に書いたとおり、発売記念イベントでミニライブが配信(無料だけどチケットは購入が必要)されるので、お時間ある方はいかがでしょうか。

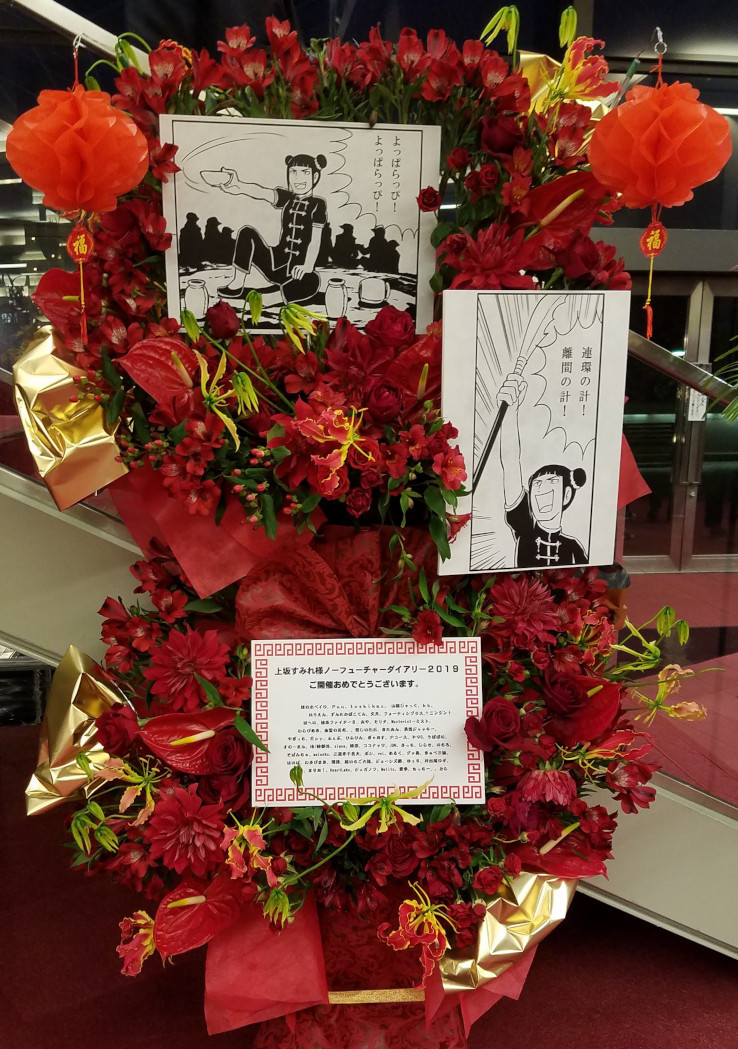

なお、1stライブの日はそのまま「上坂すみれのノーフューチャーダイアリー2019」に向かい、移動の最中にメモをしたためたのでした。

写真についてはM-4. よっぱらっぴ☆ から

100均グッズで壁掛け写真・ポスタークリップをDIY

デカジャケットや生写真、特典アイテムがとかく集まりがちな生活を送っています。

せっかくだからイイ感じにディスプレイしたくて、100均で買える材料でお手軽に「クラフト調壁掛けクリップ」を作りました。

材料は3つ(計300円)、手順も3つで簡単だったので、作り方をメモしておきます。

材料

- ペーパーストロー(クラフト)

- ワックスひも

- ウッドピンチ

ひもは、ピンチの中心に通せる太さのものにしましょう。

ひもを引っかけて使うので、無ければフックなどを買っておきましょう。

作り方

その1

ピンチは生写真なら3枚がギリギリだったので、多くても3つにしました。

その2

ここは、あまり緩くても移動してしまうし、きついと動かしづらいので調整が必要です。写真のものは結び目をつけて隙間を確保した上で、ひもが真っ直ぐに張るようにして結びました。(作り方 その3の写真)

その3

クリップを掛けるために通す2本目のひもは、ストローの長さの3倍ちょっとは確保するとちょうど良いと思います。

結ぶときは長さを調整できる結び方にすると便利です。

さいごに

あとは壁のフックに引っかけるだけです。最近は、少し凹凸のある壁でも貼って剥がせるタイプのフックがあるのでフック設置の自由度が上がっています。これも3個セットで100均にあったので買ってきて、今回使いました。

お気に入りの写真やジャケットが飾ってあるとQOLが上がりますね。

なお写真にあるメガジャケットは、Amazon.co.jp限定版(値段は同じ、というか通常版も割引なし)で買える。

THE IDOLM@STER SHINY COLORSの絵についての評判はご存じかと思いますがジャケットに至っても同様で、この大きさで手もとに置いて飽かずに眺められます、通販はヨドバシを使いたいけどメガジャケットがあるからAmazonにしてしまう程度に。

【Amazon.co.jp限定】THE IDOLM@STER SHINY COLORS GR@DATE WING 02 (デカジャケット付) 限定版

シンデレラガールズ総選挙結果データ

シンデレラガールズ総選挙結果データのデータをまとめたので、公開しておきます。Google スプレッドシートとJsonデータを用意しました。

全ての総選挙とボイスオーディションの、アイドル名と属性、中間結果・最終結果・前回順位・属性別順位・投票数・投票時のボイス有無が含まれます。 前回順位は、圏外か未登場かを区別しています。

また、ボイス実装済みアイドルの発表日、初参加楽曲・ソロ曲の制作状況の一覧も改めてスプレッドシートにまとめました。

ライセンスはNYSL Version 0.9982です。(もし私に著作権があると考えられる部分については)

これまでD3で作成したグラフ*1は、ほとんどこのJSONデータを使っています。何かグラフを作ったり調べたりしていただけると嬉しいです。

シンデレラガールズボイスと楽曲 - Google スプレッドシート

ボイス発表からソロ実装まで2,000日をギリギリ回避した上条春菜&佐々木千枝、そろそろ2,000日となってしまう大和亜季&及川雫などのデータが確認できます……。

Gist

シンデレラガールズ総選挙歴代トップレースのグラフ

アイドルマスターシンデレラガールズの総選挙歴代トップ10を動くグラフを作りました。

d3.js V4で作成。データは独自集計なので、間違いなどありましたらお知らせ頂けると有難いです。

凡例

りあむちゃん総選挙初登場3位だったけど、初めてランク入りしたときのアーニャは2位だし、鷺沢さんは6位で、しゅがはは9位なのか、など眺めてるとわかってきます。

ミリオン5thライブ楽曲購入リスト

ミリオン5thライブ楽曲購入リスト

お疲れ様です。

ミリオン5thライブの楽曲をこれから買おうという方のためのリストです。

ミリオンライブ!は楽曲が多い、ミリシタ以前のシリーズは実装されていなかったり、CDシリーズが別れていてわかりにくいですよね。

そこで、今回は5thライブに絞ったリストです。

要約

多い。CDにして29タイトル。

ソロ

- 配信サイト(下記参照)で1曲ずつ買える

- シリーズ名はM@STER SPARKLE (略称MS)

ユニット曲

2パターンあります。

オリジナルメンバーで歌った曲

- 現在展開中のTHE@TER GENERATIONシリーズ (略称MTG)

- 曲は配信で買えるけど、MTG02以降にあるドラマパートは買えない

- ドラマのためにCDを買う価値はある

- MTG05以降*1、歌った曲はアイドルがお仕事した作品の「主題歌」、ドラマが本編でエンディング曲もある!

- 「ジレるハートに火をつけて」は次の、メンバーを全く買えて歌った曲と同じ扱い

メンバーを全く変えて歌った曲

- ミリシタ以前のLIVE THE@TER PERFORMANCE (LTP)シリーズとLIVE THE@TER HARMONY (LTH)

- 曲は配信で買えるけど、ドラマパートは買えない

- ※LIVE THE@TER HARMONYには、もともとドラマパートは無い

CD未発売の曲

- MILLION THE@TER GENERATION 09 「花ざかりWeekend✿」 4Luxury [桜守歌織 (香里有佐), 豊川風花 (末柄里恵), 北上麗花 (平山笑美), 馬場このみ (高橋未奈美)] ※配信中

- MILLION THE@TER GENERATION 10「咲くは浮世の君花火」閃光☆HANABI団 [高山紗代子 (駒形友梨), 福田のり子 (浜崎奈々), 高坂海美 (上田麗奈), 佐竹美奈子 (大関英里), 横山奈緒 (渡部優衣)]

- THE@TER GENERATION 11 UNION!! (2018年8月29日発売予定)

配信サイト

リスト

ひたすらに多いので、ページ内検索(Ctrl+F)でアイドル名か役者名を入れたりして探してください。

| シリーズ | タイトル |

オリジナルメンバー/ 歌唱メンバー |

アフィリエイト |

|---|---|---|---|

| MILLION LIVE! M@STER SPARKLE 01 | ローリング△さんかく | 周防桃子 (渡部恵子) |

|

| 地球儀にない国 | 七尾百合子 (伊藤美来) | ||

| 祈りの羽根 | 豊川風花 (末柄里恵) | ||

| 瑠璃色金魚と花菖蒲 | 白石紬 (南早紀) | ||

| 未来系ドリーマー | 春日未来 (山崎はるか) | ||

| MILLION LIVE! M@STER SPARKLE 02 | プリンセス・アラモード | 徳川まつり (諏訪彩花) |

|

| HOME RUN SON♪ | 永吉昴 (斉藤佑圭) | ||

| ロケットスター☆ | 伊吹翼 (Machico) | ||

| CAT CROSSING | 北沢志保 (雨宮天) | ||

| ハミングバード | 桜守歌織 (香里有佐) | ||

| MILLION LIVE! M@STER SPARKLE 03 | Come on a Tea Party! | 箱崎星梨花 (麻倉もも) |

|

| 満腹至極フルコォス | 佐竹美奈子 (大関英里) | ||

| Only One Second | 高山紗代子 (駒形友梨) | ||

| To... | 馬場このみ (高橋未奈美) | ||

| SING MY SONG | 最上静香 (田所あずさ) | ||

| MILLION LIVE! M@STER SPARKLE 04 | AIKANE? | 野々原茜 (小笠原早紀) |

|

| スポーツ!スポーツ!スポーツ! | 高坂海美 (上田麗奈) | ||

| ART NEEDS HEART BEATS | ロコ (中村温姫) | ||

| ENTER→PLEASURE | 望月杏奈 (夏川椎菜) | ||

| あめにうたおう♪ | 矢吹可奈 (木戸衣吹) | ||

| MILLION LIVE! M@STER SPARKLE 05 | Border LINE→→→? | 百瀬莉緒 (山口立花子) |

|

| ふわりずむ | 宮尾美也 (桐谷蝶々) | ||

| たんけんぼうけん☆ハイホー隊 | 大神 環 (稲川英里) | ||

| Silent Joker | 真壁瑞希 (阿部里果) | ||

| はなしらべ | エミリー スチュアート (郁原ゆう) | ||

| MILLION LIVE! M@STER SPARKLE 06 | WE ARE ONE!! | 福田のり子 (浜崎奈々) |

|

| Home is a coming now! | 横山奈緒 (渡部優衣) | ||

| Oli Oli DISCO | 舞浜 歩 (戸田めぐみ) | ||

| ムーンゴールド | 二階堂千鶴 (野村香菜子) | ||

| スタートリップ | ジュリア (愛美) | ||

| MILLION LIVE! M@STER SPARKLE 07 | Take!3.2.1.→S・P・A・C・E↑↑ | 松田亜利沙 (村川梨衣) |

|

| ときどきシーソー | 中谷育 (原嶋あかり) | ||

| スノウレター | 木下ひなた (田村奈央) | ||

| 教えてlast note... | 篠宮可憐 (近藤唯) | ||

| Hearty!! | 所恵美 (藤井ゆきよ) | ||

| MILLION LIVE! M@STER SPARKLE 08 | シャクネツのパレード | 島原エレナ (角元明日香) |

|

| 空に手が触れる場所 | 北上麗花 (平山笑美) | ||

| Sister | 天空橋朋花 (小岩井ことり) | ||

| シルエット | 田中琴葉 (種田梨沙) | ||

| Brand New Theater! | 765 MILLION ALLSTARS | ||

| MILLION THE@TER GENERATION 01 | Brand New Theater! | 765 MILLIONSTARS |

|

| Dreaming! | 765 MILLIONSTARS | ||

| MILLION THE@TER GENERATION 02 | FairyTaleじゃいられない |

フェアリースターズ [最上静香 (田所あずさ), 白石 紬 (南 早紀), 所 恵美 (藤井ゆきよ), ジュリア (愛美), 北沢志保 (雨宮 天)] Day1: 周防桃子 (渡部恵子), 舞浜 歩 (戸田めぐみ), ロコ (中村温姫), 真壁瑞希 (阿部里果), 白石紬 (南早紀), 北沢志保 (雨宮天) Day2: 最上静香 (田所あずさ), ジュリア (愛美), 二階堂千鶴 (野村香菜子), 天空橋朋花 (小岩井ことり), 所恵美 (藤井ゆきよ), 百瀬莉緒 (山口立花子) |

|

| Brand New Theater! |

フェアリースターズ [最上静香 (田所あずさ), 白石 紬 (南 早紀), 所 恵美 (藤井ゆきよ), ジュリア (愛美), 北沢志保 (雨宮 天)] 各公演日全員 |

||

| MILLION THE@TER GENERATION 03 | Angelic Parade♪ |

エンジェルスターズ [伊吹 翼 (Machico), 桜守歌織 (香里有佐), 北上麗花 (平山笑美), 望月杏奈 (夏川椎菜), 箱崎星梨花 (麻倉もも)] Day1: 箱崎星梨花 (麻倉もも), 野々原茜 (小笠原早紀), 篠宮可憐 (近藤唯), 豊川風花 (末柄里恵), 桜守歌織 (香里有佐), 馬場このみ (高橋未奈美), 北上麗花 (平山笑美) Day2: 伊吹翼 (Machico), 木下ひなた (田村奈央), 大神 環 (稲川英里), 望月杏奈 (夏川椎菜), 宮尾美也 (桐谷蝶々), 島原エレナ (角元明日香) |

|

| Brand New Theater! |

エンジェルスターズ [伊吹 翼 (Machico), 桜守歌織 (香里有佐), 北上麗花 (平山笑美), 望月杏奈 (夏川椎菜), 箱崎星梨花 (麻倉もも)] 各公演日全員 |

||

| MILLION THE@TER GENERATION 04 | Princess Be Ambitious!! |

プリンセススターズ [春日未来 (山崎はるか), 徳川まつり (諏訪彩花), 矢吹可奈 (木戸衣吹), 七尾百合子 (伊藤美来), エミリー スチュアート (郁原ゆう)] Day1: 春日未来 (山崎はるか), 矢吹可奈 (木戸衣吹), エミリー スチュアート (郁原ゆう), 松田亜利沙 (村川梨衣), 中谷育 (原嶋あかり), 七尾百合子 (伊藤美来) Day2: 田中琴葉 (種田梨沙), 徳川まつり (諏訪彩花), 高山紗代子 (駒形友梨), 福田のり子 (浜崎奈々), 高坂海美 (上田麗奈), 佐竹美奈子 (大関英里), 横山奈緒 (渡部優衣) |

|

| Brand New Theater! |

プリンセススターズ [春日未来 (山崎はるか), 徳川まつり (諏訪彩花), 矢吹可奈 (木戸衣吹), 七尾百合子 (伊藤美来), エミリー スチュアート (郁原ゆう)] 各公演日全員 |

||

| MILLION THE@TER GENERATION 05 | 昏き星、遠い月 | 夜想令嬢 -GRAC&E NOCTURNE- [天空橋朋花 (小岩井ことり), 所恵美 (藤井ゆきよ), 二階堂千鶴 (野村香菜子), 百瀬莉緒 (山口立花子)] |

|

| MILLION THE@TER GENERATION 06 | 虹色letters | Cleasky [島原エレナ (角元明日香), 宮尾美也 (桐谷蝶々)] |

|

| MILLION THE@TER GENERATION 07 | ZETTAI x BREAK!! トゥインクルリズム | トゥインクルリズム [中谷育 (原嶋あかり), 七尾百合子 (伊藤美来), 松田亜利沙 (村川梨衣)] |

|

| MILLION THE@TER GENERATION 08 | Melty Fantasia | EScape [真壁瑞希 (阿部里果), 白石 紬 (南 早紀), 北沢志保 (雨宮 天)] |

|

| MILLION THE@TER GENERATION 09 | 花ざかりWeekend✿ | 4Luxury [桜守歌織 (香里有佐), 豊川風花 (末柄里恵), 北上麗花 (平山笑美), 馬場このみ (高橋未奈美)] |

|

| LIVE THE@TER HARMONY 08 | ドリームトラベラー |

ミックスナッツ [馬場このみ(高橋未奈美), 木下ひなた(田村奈央), 佐竹美奈子(大関英里), 中谷 育(原嶋あかり), 双海真美(下田麻美)] Day2 : 田中琴葉 (種田梨沙), 徳川まつり (諏訪彩花), 横山奈緒 (渡部優衣), ジュリア (愛美), 伊吹翼 (Machico) |

|

| LIVE THE@TER HARMONY 05 | HOME, SWEET FRIENDSHIP |

リコッタ [天海春香(中村繪里子), 周防桃子(渡部恵子), 福田のり子(浜崎奈々), 松田亜利沙(村川梨衣), 横山奈緒(渡部優衣)] Day2: 高山紗代子 (駒形友梨), 最上静香 (田所あずさ), ジュリア (愛美), 百瀬莉緒 (山口立花子), 大神 環 (稲川英里) |

|

| LIVE THE@TER HARMONY 06 | ジレるハートに火をつけて | 灼熱少女(バーニングガール) [田中琴葉(種田梨沙), 大神 環(稲川英里), 高坂海美(上田麗奈), 所 恵美(藤井ゆきよ), 宮尾美也(桐谷蝶々)] |

|

| LIVE THE@TER PERFORMANCE 04 | Blue Symphony |

如月千早 (今井麻美), 北沢志保 (雨宮天), 田中琴葉 (種田梨沙), 所恵美 (藤井ゆきよ) Day2: 徳川まつり (諏訪彩花), 佐竹美奈子 (大関英里), 二階堂千鶴 (野村香菜子), 天空橋朋花 (小岩井ことり) |

|

| LIVE THE@TER HARMONY 10 | STANDING ALIVE |

ARRIVE [篠宮可憐(近藤 唯), 四条貴音(原 由実), 島原エレナ(角元明日香), 百瀬莉緒(山口立花子), ロコ(中村温姫)] Day2: 福田のり子 (浜崎奈々), 最上静香 (田所あずさ), 木下ひなた (田村奈央), 望月杏奈 (夏川椎菜) |

|

| LIVE THE@TER HARMONY 04 | Eternal Harmony |

エターナルハーモニー [如月千早 (今井麻美), エミリー スチュアート (郁原ゆう), ジュリア (愛美), 徳川まつり (諏訪彩花), 豊川風花 (末柄里恵)] Day1: 松田亜利沙 (村川梨衣), 真壁瑞希 (阿部里果), 北沢志保 (雨宮天), 箱崎星梨花 (麻倉もも), 北上麗花 (平山笑美) |

|

| LIVE THE@TER PERFORMANCE 05 | Sentimental Venus |

水瀬伊織 (釘宮理恵), エミリー スチュアート (郁原ゆう), 真壁瑞希 (阿部里果), 百瀬莉緒 (山口立花子) Day1: 中谷育 (原嶋あかり), 周防桃子 (渡部恵子), 野々原茜 (小笠原早紀), 馬場このみ (高橋未奈美) |

|

| LIVE THE@TER PERFORMANCE 06 | Marionetteは眠らない |

星井美希 (長谷川明子), 伊吹 翼 (Machico), 北上麗花 (平山笑美), ジュリア (愛美) Day1: 春日未来 (山崎はるか), 矢吹可奈 (木戸衣吹), エミリー スチュアート (郁原ゆう), ロコ (中村温姫), 豊川風花 (末柄里恵) |

|

| LIVE THE@TER HARMONY 09 | 星屑のシンフォニア |

ミルキーウェイ [星井美希(長谷川明子), 高山紗代子(駒形友梨), 天空橋朋花(小岩井ことり), 永吉 昴(斉藤佑圭), 二階堂千鶴(野村香菜子)] Day1: 矢吹可奈 (木戸衣吹), 周防桃子 (渡部恵子), 舞浜 歩 (戸田めぐみ), 白石紬 (南早紀), 篠宮可憐 (近藤唯) |

|

| LIVE THE@TER PERFORMANCE 12 | ココロがかえる場所 |

萩原雪歩 (浅倉杏美), 周防桃子 (渡部恵子), 二階堂千鶴 (野村香菜子), ロコ (中村温姫) Day1: エミリー スチュアート (郁原ゆう), 舞浜 歩 (戸田めぐみ), 篠宮可憐 (近藤唯), 桜守歌織 (香里有佐) |

|

| LIVE THE@TER HARMONY 07 | Birth of Color |

BIRTH [菊地 真 (平田宏美), 萩原雪歩 (浅倉杏美), 舞浜 歩 (戸田めぐみ), 三浦あずさ (たかはし智秋), 矢吹可奈 (木戸衣吹)] Day1: 春日未来 (山崎はるか), 七尾百合子 (伊藤美来), ロコ (中村温姫), 箱崎星梨花 (麻倉もも), 野々原茜 (小笠原早紀) |

|

| LIVE THE@TER PERFORMANCE 01 | Thank You! |

765 MILLIONSTARS 全員 |

|

Amazonアフィリエイトリンクは Amakuri [Amazonアフィリエイトリンク作成ツール] を利用しています。